Pourquoi et comment nous sommes sortis des sentiers battus pour faire découvrir une utilisation concrète de l’IA pour accompagner le processus créatif.

Le pourquoi

Nous avons été mandatés, dans le cadre d’un événement consacré à l’IA s’étant déroulé les 23 et 24 mars 2024 à la BAnQ, pour monter et présenter un atelier d’introduction aux capacités d’accompagnement du processus créatif par l’apprentissage profond. Il est vrai que l’utilisation de l’IA dans le but de créer du contenu est un des usages les plus illustrés actuellement, et aussi l’un des plus questionnés : droit d’auteur, créativité à proprement parler des modèles d’IA, remplacement des créatifs par des algorithmes, sont des sujets parmi d’autres qui font l’objet de nombreuses discussions, y compris du coté des artistes reconnus.

Notre but avec cet atelier est de favoriser la discussion avec les participants, sur tous les sujets que touchent ces modèles génératifs. Et pour pousser la réflexion sur l’utilité de tels outils, nous avons voulu sortir des usages évidents tels que ceux proposés par les OpenAI de ce monde, c’est à dire aller plus loin que la simple génération d’une image affichée sur un écran. C’est donc naturellement que nous avons cherché un moyen d’appliquer des modèles de diffusion aux arts numériques, par l’intermédiaire d’une installation numérique dédiée.

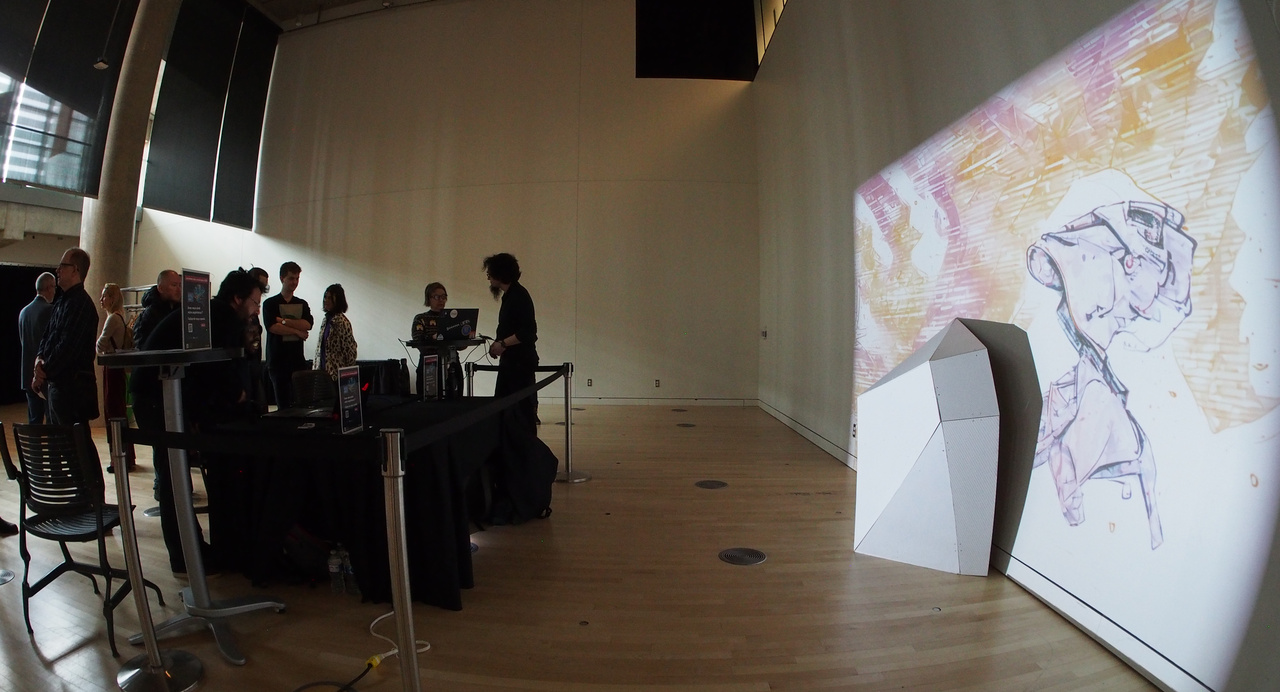

Notre proposition a donc évolué, partant d’un atelier composé de quelques stations de création permettant aux participants de tester leur capacité à tirer parti de l’IA pour faciliter leur recherche graphique 2D, pour finalement arriver à une installation numérique incluant de la projection architecturale sur une sculpture prévue à cet effet. Ceci dans l’idée de montrer que l’IA peut se révéler un véritable atout pour accompagner le processus créatif lorsque le media est inhabituel.

Le comment : construction physique

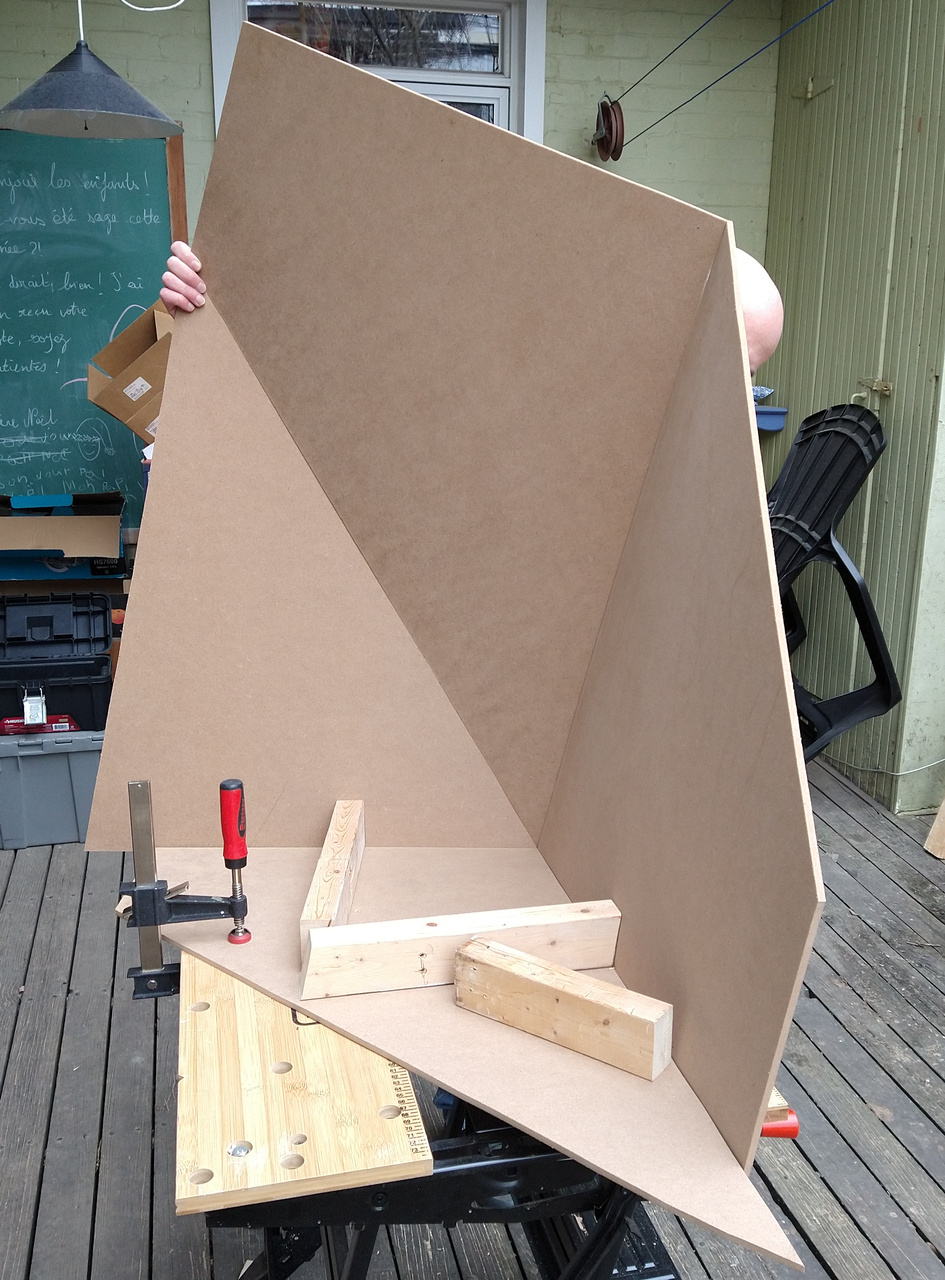

Commençons par décrire la sculpture. Nous voulions avoir une géométrie de projection qui puisse être suffisamment neutre pour ne pas trop influencer les participants, et les laisser explorer librement. Le résultat de notre réflexion s’est donc arrêté sur une patatoïde, dotée d’un nombre réduit de polygones pour faciliter sa construction. Pour augmenter le champ des possibles, nous avons choisi de placer cet objet contre un mur, l’une des faces étant plane, ce qui nous permet de prolonger le contenu au delà de la sculpture. La modélisation de l’objet a été faite avec Blender, et la fabrication à proprement parler à été faite à mains nues (ou presque) en utilisant des plaques de MDF et des charnières, le tout étant peint en blanc bien entendu.

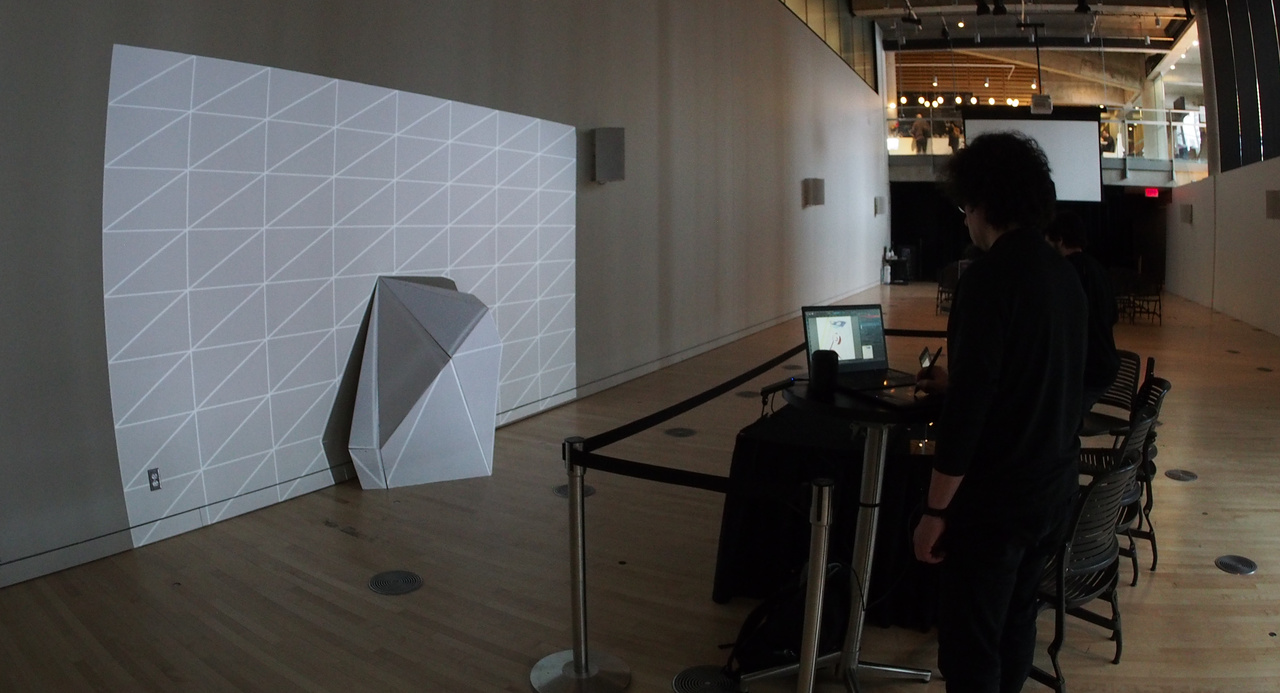

Pour ce qui est du matériel informatique, nous avons choisi de faire simple pour deux raisons : la sculpture impose d’elle même beaucoup de logistique pour son transport ; et le processus de fabrication manuel ne nous permet pas une grande précision dans les mesures. En utilisant donc un seul projecteur vidéo, le calibrage de la projection se trouve largement simplifié. Pour ce qui est des stations de création, deux ordinateurs portables dotés de tablettes graphiques ont été mises en œuvre. Et pour héberger les modèles de diffusion, nous avons opté pour nos ordinateurs de bureau équipés de cartes graphiques adaptés, accessibles à travers un VPN.

Le comment : construction logicielle

Pour ce qui est de la partie logicielle, nous avons fait appel aux outils suivantes :

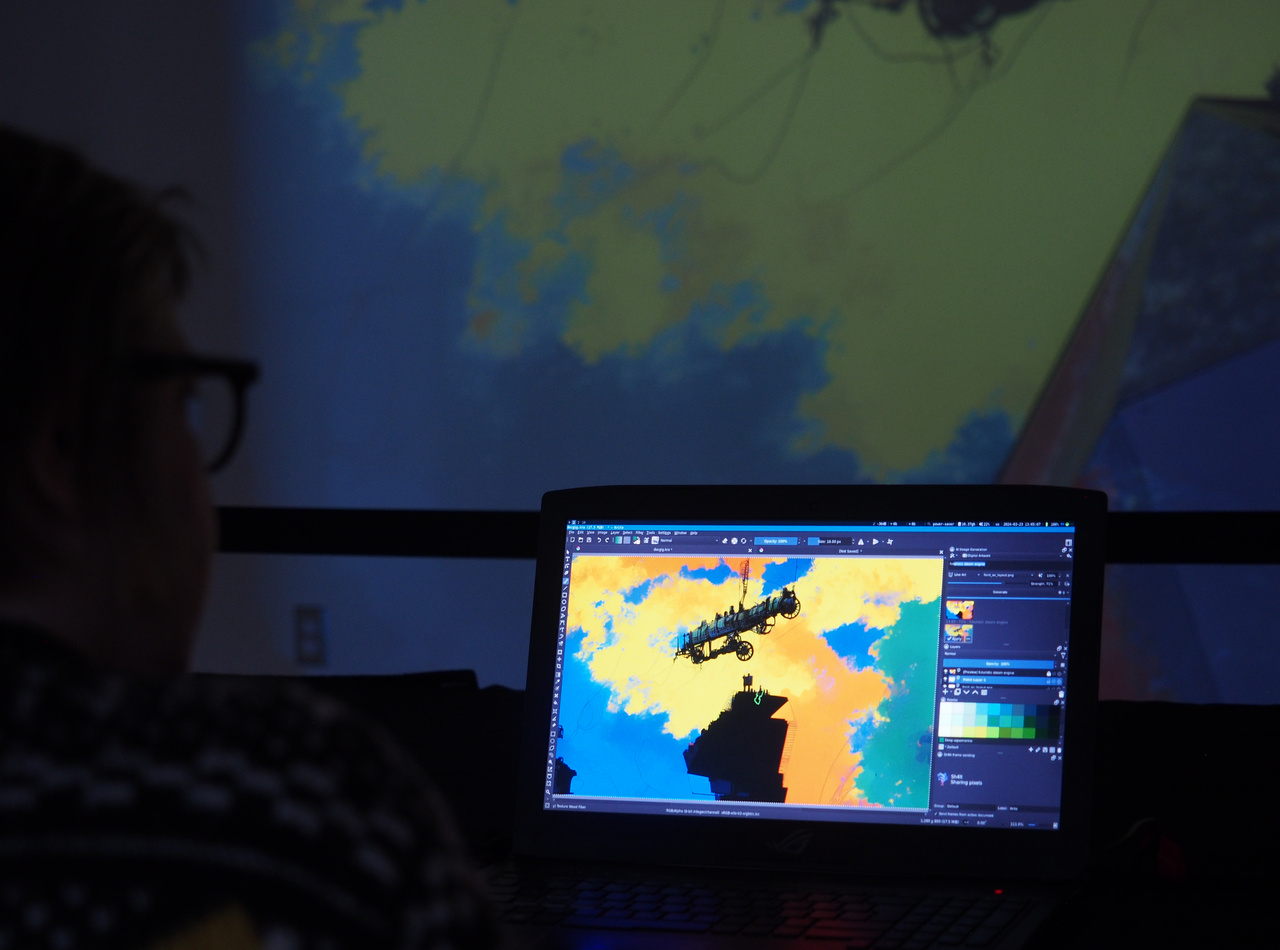

- Krita pour dessiner

- ComfyUI pour faire fonctionner les modèles de diffusion

- Krita-AI pour faire le lien entre les deux

- Splash pour le mapping vidéo

Manque dans cette liste de quoi faire communiquer Krita et Splash, pour que l’un envoie les images créés (en profitant de l’IA) à l’autre. Nous aurions pu utiliser OBS Studio et capturer une partie de l’affichage pour l’envoyer vers Splash en NDI, mais ça n’aurait pas été très robuste à l’usage. Nous avons donc développé un addon pour Krita permettant à celui-ci de partager les images éditées avec les autres processus de l’ordinateur, et reposant sur une libraire de notre conception qui permet justement cette communication : Sh4lt. Le support de Sh4lt a été également ajouté à Splash pour l’occasion.

Et pour ce qui est du transfert des images entre les deux ordinateurs portables, nous avons profité du protocole SRT à travers GStreamer, auquel le support de Sh4lt a également été ajouté. Avec tout ça nous avons été capables de relier tous ces logiciels ensemble pour permettre à deux participants de collaborer à la création du contenu projeté sur l’installation.

Réflexions et potentialités

Du point de vue de l’objectif principal de l’atelier, la forme que nous lui avons donné est une réussite. Nous avons eu beaucoup de questions, que ce soit sur les usages de l’IA générative, sa mise en œuvre technique, les implications dans l’écosystème culturel, les considérations éthiques et de propriété intellectuelle.

Pour ce qui est de nos propres envies sur la tournure que prendrait l’atelier, la prise en compte de la surface de projection comme cadre de création a été relativement limitée, et la collaboration entre les utilisateurs des deux stations à peu près inexistante. Mais il s’agit pour nous d’approches nouvelles et innovantes, ce n’est donc pas étonnant que des participants a priori sans connaissance particulière de ces outils n’aient pas été réceptifs à ces aspects. Il n’en reste pas moins que nous voulons continuer de les développer à travers d’autres projets.

À ce sujet, ce projet nous a convaincu du potentiel de l’IA générative pour assister la phase d’exploration en particulier lorsqu’il s’agit de dispositifs de diffusion sortant de l’ordinaire. Dans notre cas, la projection architecturale sur une patatoïde n’est pas exactement une pratique commune, et nous avons apprécié d’expérimenter avec ControlNet à traverse ComfyUI pour contraindre la génération à la géométrie. Beaucoup reste à faire en terme d’exploration cependant.

Pour terminer, cet atelier nous a également permis d’expérimenter avec un processus inverse pour ce qui est de la projection architecturale : nous sommes parti d’un modèle 3D pour fabriquer la structure physique, et non l’inverse. Du fait d’un budget limité nous avons fabriqué l’ensemble à la main, mais dans le futur nous envisageons de mettre en application des outils tels que la projection des plans directement sur une feuille de MDF pour faciliter le report des dimensions (une autre application du videomapping !), ou encore profiter de la découpe laser si les dimensions ne sont pas trop importantes.